Страшная сила: как мошенники используют нейросети для обмана пользователей

Искусственный интеллект с каждым годом развивается все стремительнее и сегодня задействуется во многих сферах жизни и экономики. Многие используют нейросети для работы, обучения иностранным языкам, генерации текста и изображений, а аферисты – в киберпреступлениях. Сегодня мошеннические действия с помощью AI приняли такой оборот, что так или иначе коснулись каждого второго.

В статье разберем, как именно мошенники используют нейросети для обмана пользователей и каким образом можно обезопасить свои данные в сети.

Как изменилось мошенничество с помощью нейросетей

Мошенники регулярно придумывают новые схемы для обмана пользователей. Конечно, многие приемы в ходу до сих пор – людям все еще звонят из «службы безопасности Сбербанка» и предлагают «сохранить» все деньги на якобы безопасном счете. В 2024 году преступники активизировались с новой силой. Особенно массовыми стали следующие тенденции:

- взлом аккаунтов в Telegram. Аферисты крадут учетные записи разными способами – в качестве приманок используют голосования в конкурсах, бесплатные подписки, денежные призы.

Распространенной стала схема с подарочными подписками Telegram Premium – пользователю приходит сообщение о том, что кто-то из его списка контактов подарил ему подписку. Жертва нажимает на кнопку, получает код активации. После введения кода злоумышленники получают доступ к аккаунту. Все схемы с кражей учетных записей в Telegram объединяет необходимость ввода своего номера телефона и SMS-кода.

- использование чат-ботов. Если раньше мошенники сами общались с потенциальными жертвами, то сейчас этим все чаще занимаются чат-боты. Благодаря искусственному интеллекту боты обучены генерировать и рассылать сообщения, вести переписку, разговаривать и даже флиртовать, и пользователи далеко не сразу понимают, что имеют дело не с человеком.

Что дает мошенникам использование нейросетей:

- повышение реалистичности и убедительности обмана. Сегодня нейросети умеют подделывать даже голос, поэтому мошенникам стало проще вводить пользователей в заблуждение.

- увеличение масштаба мошеннических преступлений в сети. Если обычный злоумышленник может одновременно вести переписку с 2–3 возможными жертвами, то бот – с тысячами.

- автоматизация старых схем и повышение рентабельности. В основном аферисты используют прежние сценарии, нейросети помогли сделать их более массовыми, а значит, еще прибыльнее.

Однако запрограммированные боты могут легко обнаружить себя, если собеседник отклоняется от заданного сценария в переписке. Ниже рассмотрим основные мошеннические схемы и расскажем, на что обратить внимание, чтобы распознать обман.

Как мошенники используют нейросети: основные сценарии и приемы

- Подделка голоса, фото и видео

Дипфейк – это любой медиаконтент, созданный нейросетью на основе существующего видео, изображения или звука. Стал мощным и довольно опасным инструментом в руках злоумышленников.

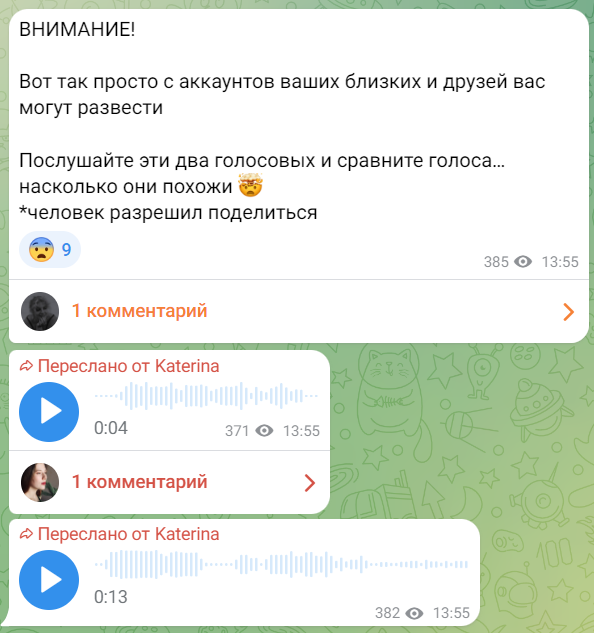

Нейросеть давно умеет копировать стиль общения человека, проанализировав его переписки в мессенджере и посты в соцсетях, но мошенники пошли дальше – в последние годы с помощью ИИ они стали активно подделывать голосовые сообщения. Аферисты получают доступ к аккаунту в Telegram, скачивают сохраненные аудиосообщения и на их основе синтезируют новые с нужным контекстом. Это точно позволяет убедительнее просить деньги – сходство практически неотличимо.

С целью вымогательства денег потенциальная жертва может получить фейковое видео или фото. Мошенники используют самые разные рычаги давления: например, отправляют видео от родственника, якобы попавшего в беду, – для решения проблемы срочно требуются деньги. Или контент интимного характера, которым начинают шантажировать. Также это может быть запись обращения президента или губернатора, объявляющего о новых выплатах, для получения которых нужно пройти по ссылке или заплатить налог.

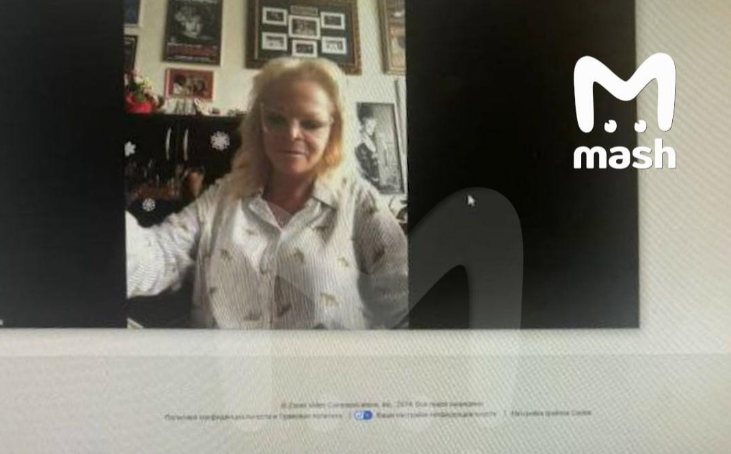

Особенно распространены дипфейки с известными личностями, так как фото и видео с ними есть в свободном доступе, и их часто используют для обучения чат-ботов. Мошенники не только отправляют заранее созданные аудио- и видеозаписи – нейросеть может сгенерировать цифровую копию человека для звонка или видеосвязи в реальном времени.

На скриншоте ниже – некто, очень похожий на Ларису Долину, общается с представителями кредитных организаций по поводу займа в 50 млн под залог ее дома. Позже выяснилось, что певицу сгенерировала нейросеть.

Неподготовленному человеку может быть сложно отличить сгенерированный нейросетью контент от реального, но для этого есть немало факторов.

Как распознать обман:

- Неестественный голос со странным темпом речи, который либо звучит монотонно и почти без пауз, либо произносит слова с задержкой и непривычной интонацией.

- Отличительная черта голосовых сообщений, сгенерированных нейросетью, – на фоне не слышно дыхания человека и других посторонних звуков.

- Слишком правильная речь без запинок, слов-паразитов, междометий, вздохов, смеха и т. д.

- Собеседник невнятно и уклончиво отвечает на вопросы, продолжает вести одну линию разговора.

- На видео, созданном при помощи искусственного интеллекта, у персонажей может наблюдаться странная мимика, несовпадение движения губ с речью, различия в оттенках кожи на лице.

- Плохое качество видео и фото, собеседник постоянно поправляет волосы, прикрывает лицо рукой, видео зависает.

2. Подделка документов

Преступники и раньше делали ненастоящие документы в фотошопе, но тогда это занимало больше времени. Искусственный интеллект же генерирует фотографии паспортов, удостоверений, любых выписок и приказов за несколько минут. Опасность в том, что мошенники могут использовать копии документов для оформления микрозаймов или подтверждения другой банковской операции, регистрации в онлайн-казино, организации подставной фирмы, аутентификации в личном кабинете банка или социальной сети.

Также мошенники подделывают официальные письма и приказы от организаций, предъявляя их как подтверждение при требовании перевода средств.

Как распознать обман:

- Внимательно рассмотреть изображение, обратить внимание на качество фото, мелкие искажения, шрифт.

- Попросить сделать фотографию документа с другого ракурса, приблизить страницу.

3. Распространение вредоносных ссылок

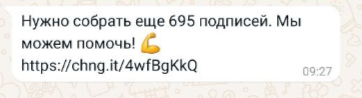

Старая схема, которая в век нейросетей получила небывалый размах. При помощи рассылки писем с вредоносными ссылками мошенники заманивают пользователей на фишинговые сайты, взламывают аккаунты, получают конфиденциальные сведения и деньги обманным путем. Сейчас чат-боты не только рассылают такие сообщения лично пользователям, но и оставляют комментарии со ссылками на фишинговые сайты к популярным постам на разных площадках. Сценарии могут быть разными – аферисты находят (к сожалению, пока успешно) разные способы воздействия на людей:

- Просьбы проголосовать за участника конкурса, оставить подпись – ссылка будет вести на фишинговый сайт, где пользователя попросят авторизоваться через мессенджер. После ввода кода подтверждения преступник получает доступ к аккаунту – никогда не делайте так.

- Предложения «активировать» бесплатную подписку, получить денежный приз или другой подарок.

- Письма с поддельными документами в виде вложений или ссылок.

- Заманчивые предложения о легкой, но прибыльной работе, распродаже товаров по супернизким ценам и т. д.

Задача искусственного интеллекта в том, чтобы составить убедительное письмо, которое побудит обычного пользователя, сотрудника компании или даже руководителя корпорации перейти по ссылке. Несмотря на то, что нейросети не отличаются эмпатией, они все больше развиваются в воссоздании портрета личности по анализу профиля из социальных сетей или заданному подробному промпту.

Как распознать обман:

- Обратите внимание на то, соответствует ли сообщение контексту, от кого пришло письмо, задайте уточняющие вопросы, игнорируя требование о срочности.

- Прикрепленные ссылки или файлы указывают на то, что сообщение, скорее всего, фишинговое.

- Внимательно прочтите сообщение – отсутствие пробелов между словами и ошибки, как правило, нужны, чтобы обойти спам-фильтры.

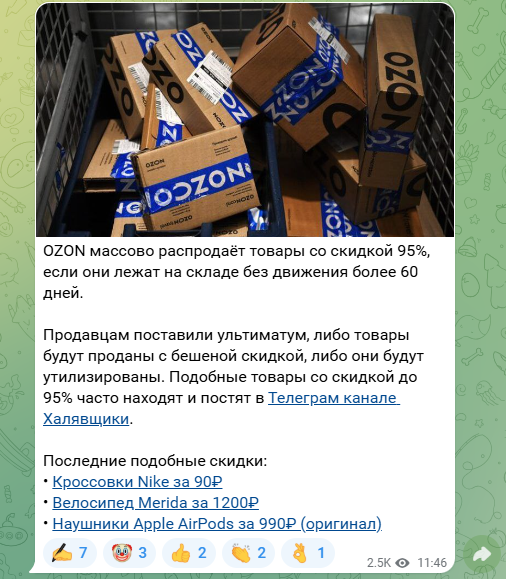

4. Продажа несуществующих товаров

Маркетплейсы прочно вошли в нашу жизнь, и сегодня люди ищут нужные вещи не только непосредственно на Wildberries и Ozon, но и делятся ссылками друг с другом, изучают подборки товаров в разных обзорах и блогах. Этим активно пользуются мошенники, распространяя подобные объявления:

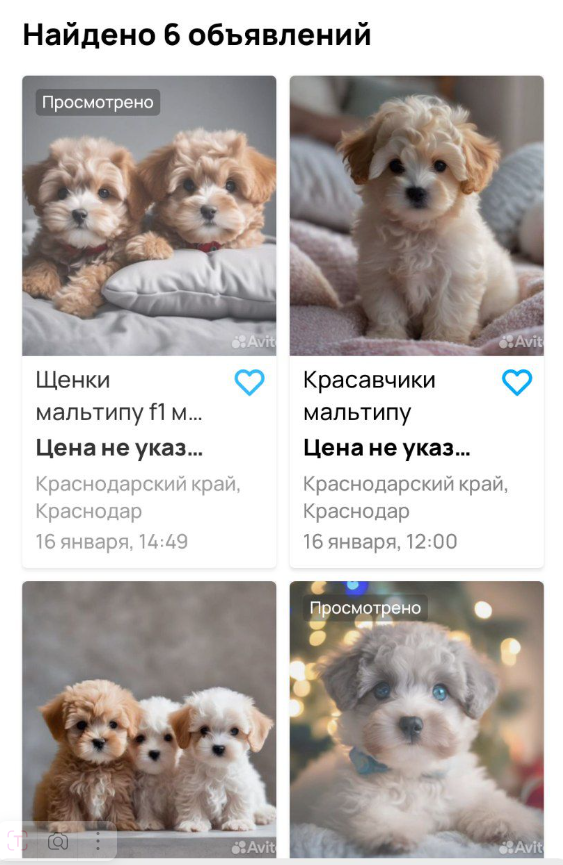

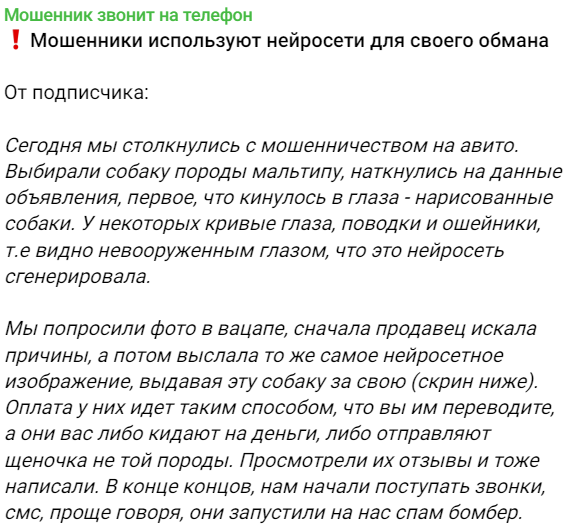

Аферисты создают объявления о продаже товаров, которых в действительности не существует. Привлекают покупателя выгодными ценами, добавляют цепляющие описания и фото, которые генерируют при помощи нейросетей. Ниже – реальная история из телеграм-канала «Мошенник звонит на телефон»:

Часто такие объявления выглядят вполне реалистично, и пользователи почти не сомневаются в их подлинности. Фейковые карточки товаров публикуют прямо на маркетплейсах или на досках объявлений, но после получения заказа злоумышленники просят покупателя связаться с продавцом в мессенджере, скидывают ссылку для оплаты через сторонние сервисы, а после поступления средств пропадают. Так как товар оплачен в обход площадки, жертва просто теряет деньги.

Как распознать обман:

- Оцените реалистичность фотографий: изображение может иметь замыленные участки либо быть неестественно качественным.

- Присмотритесь к деталям: нейросеть может добавлять лишние элементы, создавать снимки в неправдоподобных ракурсах, допускать недочеты в описании товара.

- Изучите отзывы – вероятно, другие пользователи уже жаловались, что в реальности получили совершенно не то, что заказывали. Если комментариев нет, поищите продавца на других площадках и в поисковике. Если упоминания отсутствуют, покупать у такого продавца лучше не стоит.

5. Создание фейковых новостей

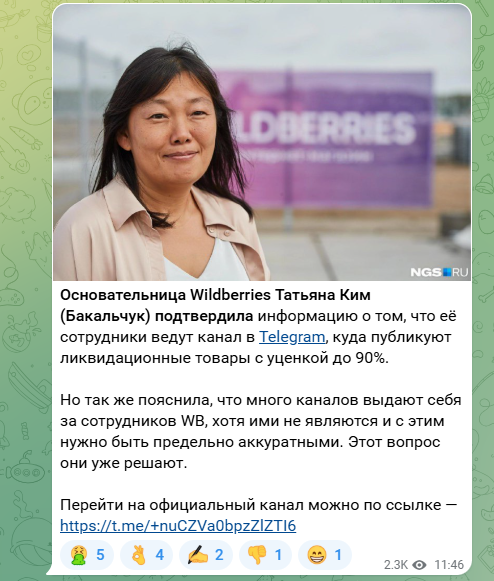

С появлением нейросетей в интернете стало еще больше недостоверной информации. Какие-то статьи с ложными сведениями распространяют по неопытности, подготовив материал с помощью искусственного интеллекта и не сделав фактчекинг. А некоторые «новости» выпускают специально в развлекательных целях, в ходе информационной войны или с мошенническим умыслом. Нейросети обучают создавать новости и генерировать изображения на аналогичном контенте, который уже есть в сети.

Новость на примере ниже визуально очень похожа на настоящую – есть отсылка к официальному лицу, на изображении логотип СМИ и даже указан сам телеграм-канал. Правда, ссылка на него ведет фишинговая.

Как распознать обман:

- Обратите внимание на первоисточник новости. Если его нет, поищите, что об этом инфоповоде пишут в авторитетных СМИ, в соцсетях и на официальном сайте какой-либо компании, ведомства или известного человека. На примере выше подтверждением информации могла бы стать ссылка на сообщение в официальных соцсетях Татьяны Ким или WB.

- Стоит насторожиться при упоминании несуществующих явлений, шокирующих результатах исследований, внезапных изменений в законодательстве и т. д. Бот часто грешит фактическими ошибками и смысловыми несостыковками.

6. Имитация сотрудника банка или другой службы

По-прежнему распространены случаи, когда мошенники звонят или пишут жертве под видом сотрудника банка, полиции, представителя мобильного оператора или другой службы. Либо с человеком разговаривает бот, либо аферисты используют нейросети для составления сообщений, подсказок фраз и выражений, которые можно услышать от работника конкретной организации.

Цель преступника – получить конфиденциальные данные, доступ к личному кабинету банковского приложения или к учетной записи на Госуслугах.

Как распознать обман:

- Задавайте уточняющие вопросы – имя сотрудника, адрес отделения, срок действия договора, дату последнего обращения.

- Обращайте внимание на несостыковки: Центробанк не работает с физлицами, представители мобильного оператора связи не звонят по мессенджеру, сотрудники полиции предпочитают разговаривать лично, а не по телефону.

- Заканчивайте разговор, если у вас запрашивают данные паспорта или карты – настоящие сотрудники не могут этого делать.

7. Обман через флирт в сети

Участились случаи, когда мошенники выдают себя за парня или девушку с сайта знакомств, либо пишут пользователю сразу в WhatsApp или Telegram. Схема опять же не новая, но получившая с развитием искусственного интеллекта второе дыхание. С помощью ИИ мошенник может сгенерировать фотографию вымышленного человека, чтобы создать профиль на сайте онлайн-знакомств.

Некоторые нейросети помогают мошенникам флиртовать – например, LoveGPT может составить сообщения, которые помогут завязать разговор, и ответы на реплики собеседника. Но так как бот общается по заданному сценарию, пользователь может быстро понять, что имеет дело с мошенником:

Цели могут быть разными: предложить вложиться в инвестиционный проект, скинуть ссылку на фишинговый сайт с намерением получить деньги или личные данные.

Как распознать обман:

- Не пропускайте странности в общении, формальные ответы, слишком восторженные отклики и фразы невпопад. Задайте вопрос вне контекста переписки – реальный человек удивится, а бот продолжит прежнюю линию разговора.

- Просьбы перейти по ссылке или отправить деньги прямым текстом говорят о том, что вы имеете дело с мошенником.

Как защититься от мошенников в интернете

Применение нейросетей в мошеннических схемах опасно тем, что позволяет аферистам использовать несколько факторов идентификации – аккаунт знакомого человека, его документы и даже голос или лицо. Не нужно становиться параноиком, но определенно стоит принять некоторые меры безопасности и держать в уме несколько рекомендаций на экстренный случай:

- Установите надежные пароли для всех мессенджеров и аккаунтов в соцсетях. Проверьте, подключена ли в Telegram двухфакторная аутентификация, а если нет, обязательно установите ее. В этом случае мошенникам потребуется еще и пароль от вашего аккаунта, который знаете только вы.

- Не сообщайте никому паспортные данные, данные карты, коды из смс – эта информация строго конфиденциальна, и никто не может запрашивать ее.

- Не паникуйте и возьмите паузу. Аферисты всегда давят на срочность, запугивают и не дают времени подумать. Узнайте, как ситуация обстоит на самом деле – позвоните в банк, свяжитесь с близким человеком, которому якобы грозит опасность или нужны деньги в долг, только не делайте этого в мессенджере.

- Мыслите критически. Проверяйте информацию или условия договора, решайте серьезные вопросы только в отделении банка или полиции.

- Не забывайте поговорку про бесплатный сыр. Проверяйте информацию о конкурсе, в котором вы якобы что-то выиграли, сведения о продавце, который предлагает дорогой товар по бросовой цене и т. д.

- Не переходите в мессенджеры при покупке товаров, не оплачивайте заказ по ссылкам на сторонние сервисы – любая коммуникация и оплата должна проходить только внутри маркетплейса. Если вести переписку вне площадки, техподдержка не сможет проверить подлинность сообщений. Обращайте внимание на адреса и домены любых сайтов, где вводите данные для оплаты.

- Проверяйте информацию, прежде чем перевести деньги на благотворительность, вложить в инвестиционный проект и т. д. Удостоверьтесь, что такой фонд или человек действительно существуют, найдите их официальные страницы и сверьте данные для перевода средств.

- Не переходите по ссылкам для голосования в конкурсах, активации подарочной подписки и с заманчивыми предложениями. Проверьте, кто вам пишет – спросите то, что можете знать только вы и ваш собеседник.

- Не соглашайтесь на условия мошенников. Если вас шантажируют, делайте скриншоты переписки и обращайтесь в полицию.

- Не отмахивайтесь от подозрительных деталей. Задумайтесь, почему друг просит перевести деньги на счет в малоизвестном банке, а не по своему номеру телефона? Не покупайте товар, если фотографии кажутся сомнительными.

- Установите спам-защиту от нежелательных звонков, это поможет отфильтровать вызовы с подозрительных номеров.

Как нейросети борются с мошенничеством в сети

Возможности искусственного интеллекта используют и для того, чтобы уменьшать количество мошеннических действий в интернете. Разрабатываются и внедряются программы, которые помогают бороться с аферистами.

Определители номера и другие функции с ИИ

Операторы сотовой связи не первый год изучают возможности нейросетей и уже внедрили несколько специальных программ для проверки номера по своим базам данных. Абонента предупреждают о спам-сообщениях, звонках из банков и вызовах с подозрительных номеров.

База биометрических данных

Голоса мошенников предлагают хранить в специальной базе данных, чтобы при помощи нейросети мобильные операторы могли распознать голос афериста, предупредить пользователя и разорвать соединение. Такой законопроект подготовило Минцифры.

Эффективность идеи пока под вопросом. Какова ее целесообразность, если преступники меняют голос посредством нейросетей? Многие считают, что собрать такую базу вряд ли возможно. Кроме того, любой алгоритм на основе искусственного интеллекта в первое время использования выдает немало ошибок и, скорее всего, будет неправильно определять голос, и тогда в базу могут попасть голоса людей, не имеющих отношение к мошенникам.

Тем не менее, сама идея неплохая, так как ИИ может анализировать другие черты речи говорящего, что будет полезно для выявления манипулятивных действий.

Технология Liveness

Это алгоритм проверки пользователя, который может отличить реального человека от его цифровой копии. Технология изучает мельчайшие движения, реакцию на свет и даже текстуру кожи. Liveness используют банки и различные интернет-сервисы для обеспечения надежной защиты личных данных.

Нейробабушка Дейзи

Бот на базе искусственного интеллекта, задача которого – разозлить мошенника и отнять его время. Работает это так: звонки с подозрительных номеров переводятся на бота, который отвечает голосом бабушки и специально путает цифры, забывает, о чем говорил минуту назад, и подолгу думает над ответом, испытывая терпение преступника. Придумали Дейзи в Великобритании – хвала английскому юмору.

Вместо итогов

И все же самым главным оружием в борьбе с сетевыми мошенниками остается повышение цифровой грамотности. Чем больше люди будут знать о самых разных схемах аферистов в интернете, тем сложнее их будет обмануть. Освещение громких случаев, распространение информации о доступных мерах защиты и обмен опытом помогут сразу обнаружить обман и не стать очередной жертвой мошенников.